-

Проблемы, вызванные дублирующимися данными

-

Категории дублирующихся данных в резервных копиях

-

Что такое дедупликация?

-

Как узнать, эффективна ли дедупликация для данных?

-

Создание рациональной стратегии бэкапа для уменьшения дублирующихся данных

-

Какое ПО для бэкапа является лучшим?

-

FAQs о дедупликации данных при резервном копировании

-

Заключение

Резервное копирование данных обеспечивает возможность быстрого восстановления работы предприятия в случае их утраты из-за отказа оборудования, природных катастроф, человеческих ошибок или злонамеренных атак, минимизируя время простоя и убытки. Однако одной из часто упускаемых из виду, но крайне важных проблем в процессе резервного копирования является наличие дублирующихся данных. Под дублирующимися данными понимаются идентичные или избыточные данные внутри набора резервных копий. Эта проблема может возникать при многократном копировании одних и тех же данных, отсутствии удаления старых версий после обновлений или неправильной стратегии резервного копирования.

Проблемы, вызванные дублирующимися данными

Дублирующиеся данные не только потребляют ценные ресурсы хранения и увеличивают затраты на хранение, но также могут усложнить и сделать менее эффективными процессы резервного копирования и восстановления. Когда набор резервных копий содержит большое количество дублирующихся данных, каждая операция резервного копирования должна обрабатывать и передавать это избыточное содержимое, что тратит сетевые ресурсы и продлевает время резервного копирования. В процессе восстановления данных дублирующиеся данные также увеличивают сложность и время, необходимые для этого, поскольку система должна просеивать и определять файлы, которые действительно нужно восстановить.

Кроме того, дублирующиеся данные могут усложнить управление данными. Большое количество дублирующихся данных делает управление данными более сложным, увеличивая сложность и стоимость обслуживания. Кроме того, дублирующиеся данные могут скрывать реальные изменения в данных, мешая анализу данных.

Поэтому решение проблемы дублирования данных в резервных копиях является критически важным. Используя эффективные методы удаления дубликатов, можно оптимизировать процесс резервного копирования, улучшить использование хранилищ и эффективность резервного копирования, снизить затраты и обеспечить точность и управляемость данных.

Категории дублирующихся данных в резервных копиях

Дублирование на уровне файлов: Целый файл создается в резервной копии несколько раз, причем каждая резервная копия является полной копией файла. Это типично для полных резервных копий папок или целых систем.

Дублирование на уровне блоков данных: Блоки данных внутри файла сохраняются избыточно в нескольких резервных копиях. Это более тонкий случай, но он может привести к значительным потерям пространства для хранения. Для обнаружения и устранения дублирования на уровне блоков обычно требуется специализированная технология дедупликации.

Дублирование версий: Сохраняется несколько версий одного и того же файла, при этом каждая версия содержит незначительные отличия, но в основном одни и те же данные.

Дублирование метаданных: При резервном копировании также могут избыточно сохраняться метаданные файлов (например, время создания или изменения). Хотя эти данные занимают относительно мало места, в масштабных резервных копиях они могут существенно накапливаться.

Что такое дедупликация?

Технология дедупликации оптимизирует использование пространства для хранения, идентифицируя и устраняя дублирующиеся блоки данных. Этот процесс основан на создании уникальных цифровых подписей (фингерпринтов) для каждого блока данных и использовании хеширования для обнаружения дубликатов. В зависимости от момента внедрения дедупликация делится на два основных типа: inline (онлайн) и post-process (офлайн). Inline-дедупликация применяется до записи данных на хранилище, сохраняя только уникальные сегменты данных, тогда как post-process дедупликация оптимизирует данные после их записи. Кроме того, по месту выполнения дедупликацию можно разделить на дедупликацию на стороне источника и на стороне цели. Дедупликация на стороне источника обрабатывает данные до их передачи, эффективно сокращая объем передачи по сети.

Ранее технология SIS (Single Instance Storage) представляла собой форму дедупликации, работающую на уровне файлов. Современная технология дедупликации работает на уровне блоков данных, обеспечивая более высокую эффективность дедупликации, но с большей сложностью реализации. Инкрементные резервные копии могут частично сократить дублирование данных, однако, поскольку они работают на уровне файлов, их точность невелика, и долгосрочное использование инкрементных копий является непрактичным из-за сложности процесса восстановления.

Технология дедупликации подходит не только для резервных и архивных систем, но также может применяться в онлайн, nearline и оффлайн системах хранения данных, включая файловые системы, менеджеры томов, NAS, SAN и другие сценарии.

Как узнать, эффективна ли дедупликация для данных?

Эффективность дедупликации зависит от нескольких факторов:

А. Объем изменений данных: Чем меньше данные изменяются, тем более эффективным будет устранение дубликатов.

Б. Сжимаемость данных: Технология сжатия обычно используется вместе с удалением дубликатов. Данные с высокой степенью сжимаемости могут значительно экономить пропускную способность и место хранения даже в том случае, если соотношение удаления дубликатов не велико.

C. Период хранения данных: Чем дольше данные хранятся, тем более выгодной становится дедупликация, так как она может существенно сократить требования к объему хранилища.

Создание рациональной стратегии бэкапа для уменьшения дублирующихся данных

Для создания разумной стратегии резервного копирования для сокращения дублирующихся данных можно предпринять следующие меры:

1. Сочетание полного и инкрементного резервного копирования: выполняйте полные резервные копии вначале или после важных обновлений данных для создания полной копии данных; используйте инкрементное резервное копирование ежедневно для записи новых изменений, сокращая дублирующие данные и экономя ресурсы.

2. Внедрение политик архивирования и очистки: устанавливайте регулярные планы архивирования для перемещения редко используемых, но необходимых данных на низкозатратное хранилище; выявляйте и удаляйте дублирующиеся или устаревшие данные, устанавливайте сроки хранения данных и автоматизируйте процесс очистки.

3. Оптимизация процесса резервного копирования: выберите программное обеспечение для резервного копирования, которое поддерживает удаление дубликатов, что автоматически удаляет дублирующиеся данные во время резервного копирования; сжимайте и шифруйте архивированные данные для дальнейшей экономии пространства и повышения безопасности.

4. Непрерывный мониторинг и корректировка стратегии: регулярно проверяйте эффективность резервных копий данных, отслеживайте использование хранилища и корректируйте стратегии резервного копирования и архивирования по мере необходимости на основе изменений в бизнесе для обеспечения эффективной работы и соблюдения требований.

Какое ПО для бэкапа является лучшим?

Vinchin Backup & Recovery является профессиональным программным обеспечением для резервного копирования виртуальных машин, которое поддерживает более 15 платформ виртуализации, включая VMware, Hyper-V, Proxmox, XenServer и oVirt и т.д. Оно предлагает отличные функции резервного копирования и восстановления виртуальных машин, а также позволяет выполнить миграцию между платформами.

Vinchin Backup & Recovery также включает функции дедупликации и сжатия. Оно предлагает настраиваемую функцию дедупликации с размером блоков, что дает больше преимуществ по сравнению с традиционной фиксированной дедупликацией, эффективно снижая объем занимаемого хранилища для резервных копий.

Приняв технологию дедупликации и сжатия от Vinchin, вы можете повысить скорость резервного копирования в процессе хранения резервных копий и сократить ресурсы хранилища, занятые резервными данными, а также устранить риск глобальной коррупции данных, вызванной глобальной дедупликацией.

Чтобы включить дедупликацию во время резервного копирования, выполните следующие шаги:

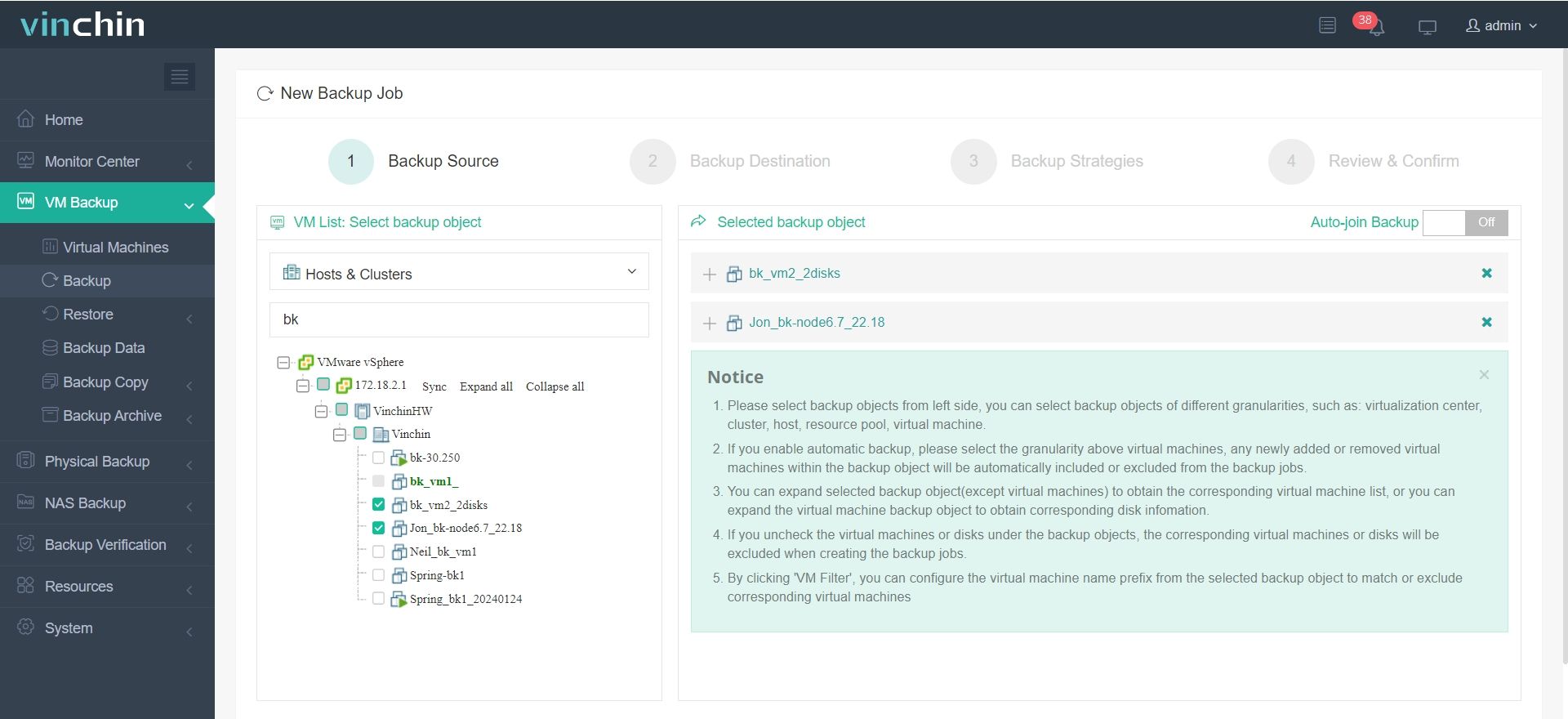

1. Выберите ВМ, которую хотите резервировать.

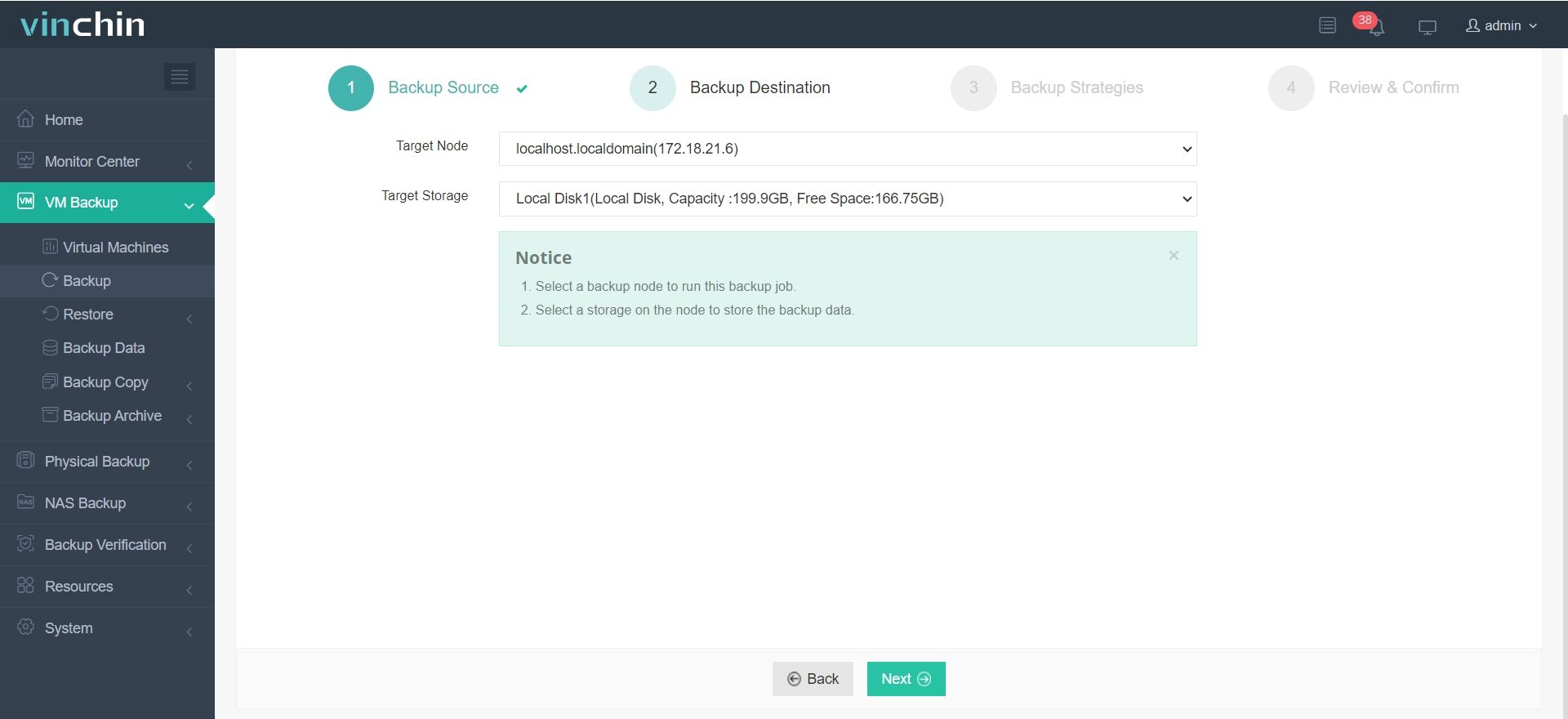

2. Выберите место назначения резервной копии.

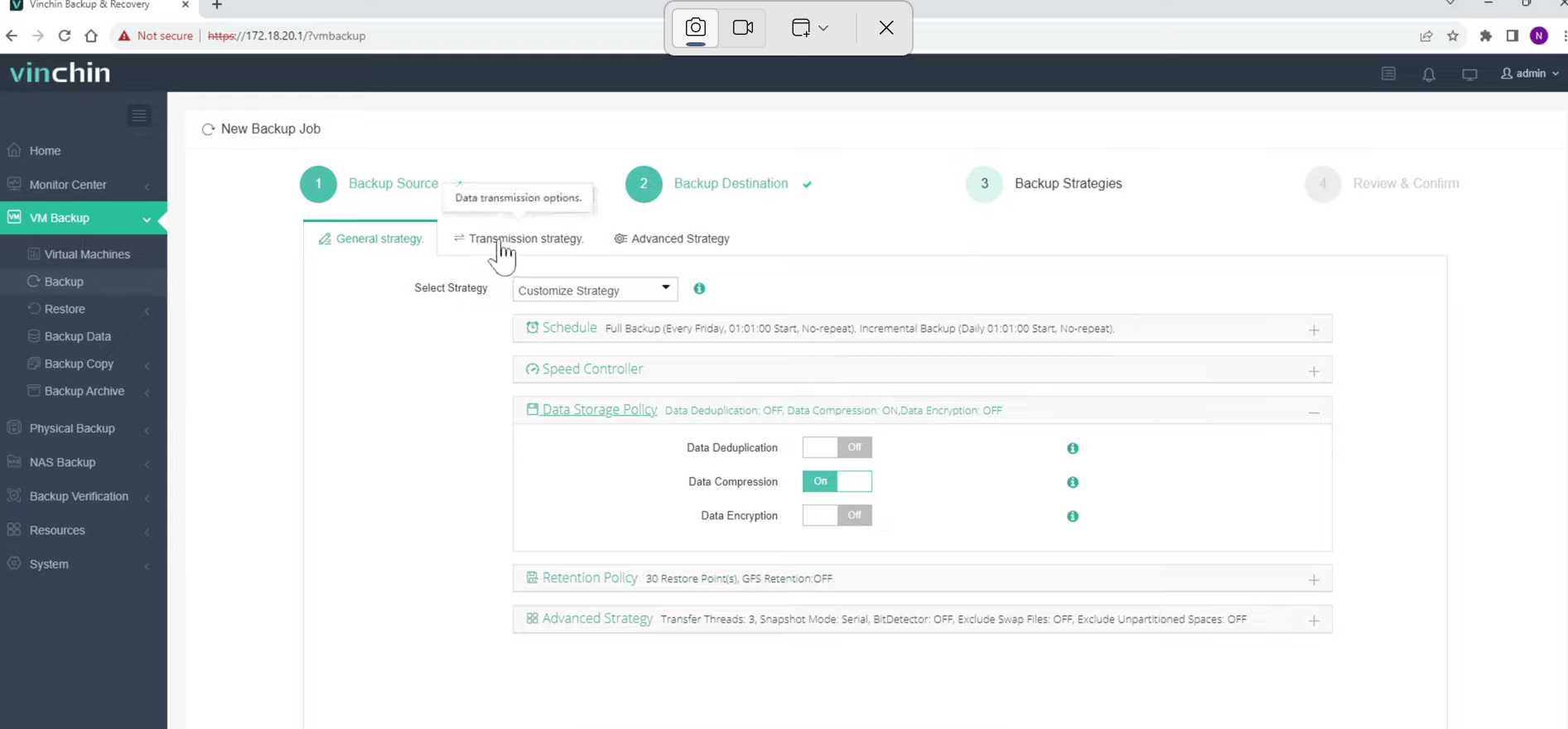

3. Настройте стратегии резервного копирования.

В разделе "Data Storage Policy" вы можете выбрать, включить ли дедупликацию и сжатие.

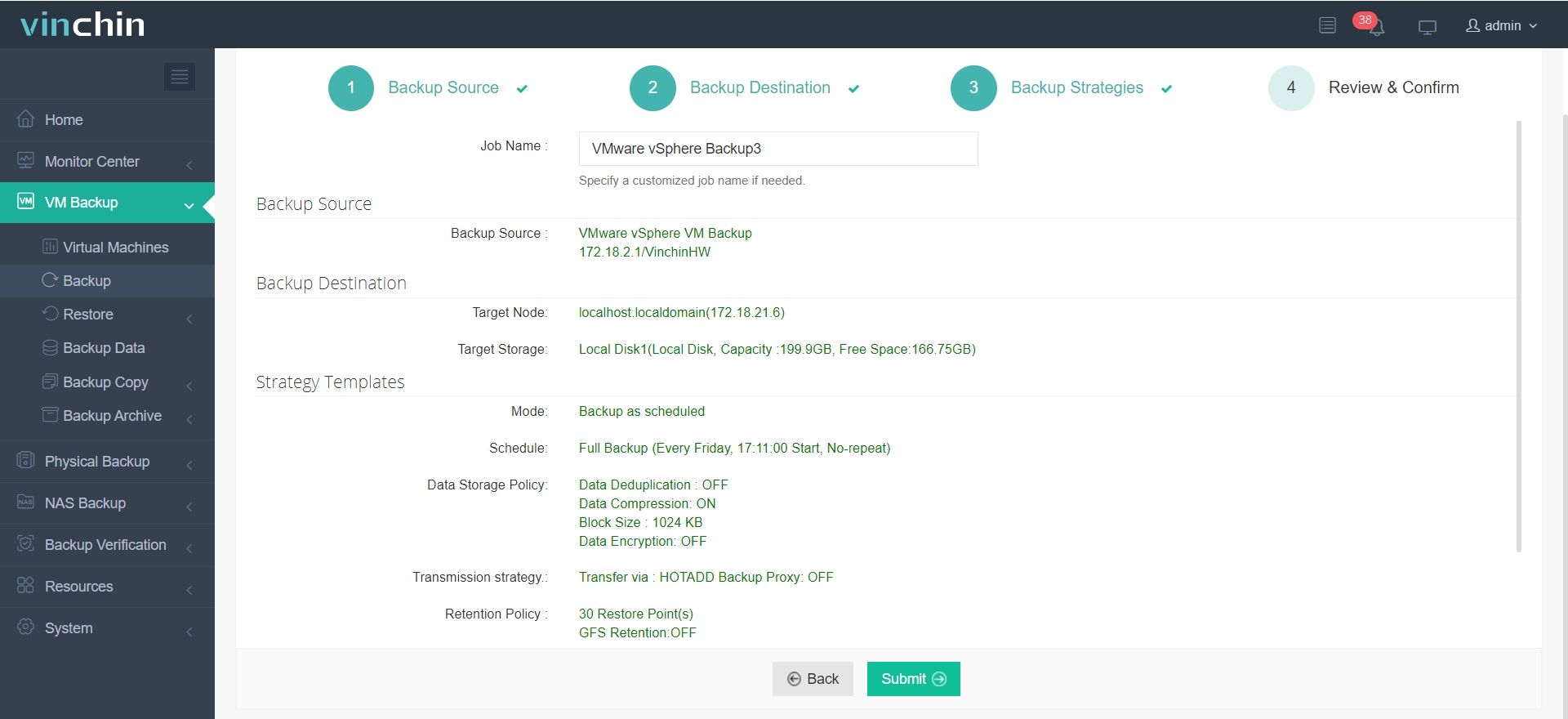

4. Подтвердите задание резервного копирования.

Помимо упомянутых функций, Vinchin предлагает множество других передовых возможностей, которые ждут вашего открытия. Нажмите на кнопку ниже, чтобы начать 60-дневную бесплатную пробную версию с полным набором функций!

FAQs о дедупликации данных при резервном копировании

1. В: Какие типы данных подходят для дедупликации, а какие нет?

О: Дедупликация подходит для любого типа данных, включая офисные документы, базы данных, мультимедийные файлы и виртуальные машины. Хотя некоторые данные могут не показывать значительных эффектов дедупликации при первом резервном копировании из-за их особенностей, преимущества дедупликации становятся очевидными при последующих копиях. Чем чаще выполняется резервное копирование и короче интервалы между ними, тем выше коэффициент дедупликации.

2. В: Что такое дедупликация с фиксированной длиной блока и дедупликация с переменной длиной блока?

О: Дедупликация с фиксированной длиной блока делит данные на блоки фиксированного размера и идентифицирует дубликаты, сравнивая содержимое каждого блока. Этот метод прост, но может упустить возможность устранить избыточность, если одинаковые данные немного сдвинуты. Дедупликация с переменной длиной блока делит данные на блоки разного размера на основе их содержимого, что позволяет более точно выявлять дубликаты, даже если данные изменили расположение. Это делает дедупликацию с переменной длиной блока более эффективной для уменьшения объема хранилища, хотя её реализация более сложна.

Заключение

Дублирующиеся данные не только занимают лишнее место на хранилище, увеличивая операционные расходы компаний, но также могут снижать эффективность резервного копирования и восстановления, усложняя управление данными. Поэтому использование эффективной технологии дедупликации для сокращения объема дублирующихся данных имеет решающее значение. С помощью дедупликации компании могут оптимизировать использование пространства, снизить затраты и повысить эффективность и точность управления данными.

поделиться: